ARTE EN LA ERA DE LA INTELIGENCIA ARTIFICIAL

MEIAC (Museo Extremeño a Iberoamericano de Arte Contemporáneo)

Badajoz, España.

Inauguración: 19 de febrero de 2021

ARTE EN LA ERA DE LA INTELIGENCIA ARTIFICIAL

MEIAC (Museo Extremeño a Iberoamericano de Arte Contemporáneo)

Badajoz, España.

Inauguración: 19 de febrero de 2021

A las cero horas del 1 de enero de 1970, daba comienzo una nueva era: empezaba a correr el reloj UNIX, en base al cual miden el tiempo prácticamente todos nuestros dispositivos tecnológicos. Teléfonos, servidores de internet, robots, cajeros automáticos, todos necesitan para poder comunicarse, establecer un “ahora”, un tiempo simultáneo de operación, y a partir de allí, un pasado y un futuro. Esa convención, gracias a la cual comenzaron a interactuar hombres y máquinas, es el tiempo UNIX, un sistema que cuenta los segundos transcurridos desde la medianoche en que dio comienzo el año 1970. Al tomarse la decisión de utilizar un número de 32 dígitos -ceros o unos-, el reloj finalizará un primer ciclo completo el martes 19 de enero de 2038, momento en el que se habrá acabado esta primera era de 32 bits.

¿Pero qué es lo que caracteriza a esta era? ¿Qué la hace diferente a otros momentos históricos en los que tuvo una decisiva influencia un determinado avance tecnológico?

La diferencia principal es que la acción de lo digital y, principalmente, su motor, el código informático, no sólo es disruptivo en relación con tecnologías anteriores, sino que está socavando los propios basamentos sobre los que la sociedad se organiza. El sunami que representa el proceso de digitalización se caracteriza por su acción incesante de desterritorialización y descodificación de todas las estructuras que encuentra a su paso.

Desde aquel primer mensaje en ARPANET a finales de 1969 hasta el último tweet de hoy, la red se ha ido estructurando hasta convertirse en un invisible gigante omnipresente, colándose hasta en el último rincón del planeta. Los cambios que está produciendo, utilizando terminología informática, no han conducido a un simple "upgrade" del sistema, sino que lo están obligando a un cambio radical de su "arquitectura". Somos testigos de cómo este efecto erosivo del código ha alterado -y alterará- progresivamente todas las estructuras que paradójicamente ha venido a asistir, hasta finalmente reemplazarlas por nuevos sistemas. Bancos, fábricas, instituciones públicas, infraestructuras, gobiernos, fronteras, escuelas, museos… todo está amenazado por su carácter disruptivo, socavando jerarquías, privilegios o antiguas convenciones.

Es en este nuevo entorno maquínico digital en el que nos deberemos desenvolver, y nuestro rol, en tanto humanos, ya no es el dominante. Friedrich Kittler dirá que "somos nosotros quienes nos adaptamos a la máquina. La máquina no se adapta a nosotros" 1. Moviendo del centro de la escena al ser humano, y enfocándose directamente en los dispositivos, Kittler disiente con McLuhan y su visión de los medios como prótesis del cuerpo ya que, según él, la tecnología sigue su propio camino evolutivo. En todo caso, en relación con los sentidos humanos, el teórico alemán consideraba que los dispositivos no sólo no pretenden mejorarlos, sino que buscan reemplazarlos, debido a su mayor eficiencia y su menor nivel de error.

1- “After all, it is we who adapt to the machine. The machine does not adapt to us.", Friedrich Kittler, en una entrevista realizada en 2006, recogida luego en el periódico The Guardian, 2011.

Lo que hace 25 años asombraba, seducía y a la vez inquietaba a la sociedad, era la proliferación y omnipresencia de la pantalla. Tanto las pantallas televisivas como las de los dispositivos digitales, comenzaban a inundar el espacio privado y el público. En su libro Pantalla Total, Jean Baudrillard, refería a la imagen electrónica en cuanto a su capacidad de abolir las distancias, eliminar los opuestos, hacer desaparecer la realidad y de ocupar su lugar convertida en simulacro, en pura superficie. Una superficie vacía en la que nos proyectamos tanto como espectadores -la pantalla de la televisión-, como operadores -la pantalla del ordenador-. Sin embargo, muy por debajo de esa capa espectacular y de modo casi invisible, lo que comenzaba a funcionar y a expandirse incluso más rápidamente que lo que se multiplicaban las imágenes, era el código informático. Muy lejos de la interfaz y la pantalla, pero muy cerca del hardware, su estructura de unos y ceros surge del circuito integrado sin generar ningún signo que pueda ser reconocible para el ser humano. Según Baudrillard, será el código el responsable de anular lo real para abrir paso a la “hiperrealidad”.

Debido a esto, vemos que la dinámica actual desborda ampliamente el dominio de la pantalla. De la pantalla total hemos pasado a la algoritmia total. Los móviles, por ejemplo, dispositivos omnipresentes, no se limitan a diseminar imágenes virtuales, sino que son los mecanismos que nos conectan a diversos agenciamientos, que, con sus sensores, recogen y transmiten nuestros datos. Ya no estamos en presencia de una multitud de pantallas que emiten información - o nos someten a una sujeción maquínica-, sino que somos parte de una red de mecanismos que procesan nuestro comportamiento y los convierten en mercancía. Inmersos en un ecosistema de algoritmos que compiten por nuestra atención, ya no somos el “target” de la propaganda -comercial o política-, sino que nos hemos transformado en el producto, en su mercancía.

Dentro de esta nueva dinámica de relaciones, uno de los conceptos que se presenta en crisis es la noción de sujeto (sujeto humano o sujeto máquina), ante la disolución de la propia idea de cuerpo autónomo, cerrado, autopoiético. Tal vez lo más adecuado sería analizar este ensamblaje de elementos dispares entre humanos y máquinas, desde la noción de agenciamiento.

Deleuze y Guattari lo definen como una interrelación de agentes heterogéneos, que comparten un territorio y tienen un devenir. El ejemplo clásico es el agenciamiento conformado por el jinete, el caballo y el estribo. Este conjunto, que no puede resumirse a la suma de las partes, se transformó en un arma decisiva en las guerras del medioevo, definiendo, por ejemplo, el resultado de la batalla de Poitiers (732), en la que la caballería de Carlos Martel se impuso ante un enemigo que, aún superior en número, no contaba con dicha tecnología, frenando definitivamente el avance del ejército de Al-Ándalus sobre Europa.

Otro ejemplo de agenciamiento similar acaba de surgir en nuestros días, más precisamente en diciembre de 2020, cuando las Fuerzas Armadas de los EE. UU. permitieron que la inteligencia artificial actuara como copiloto de un avión militar. Un hito que para los propios militares marcó el comienzo de un nuevo escenario bélico: el de la "guerra algorítmica".

El piloto, identificado como el mayor “Vudu” y ARTUµ 2, una versión modificada de μZero, un algoritmo de juego que supera a los humanos en juegos como el ajedrez y el Go, volaron un avión espía U-2 en una misión de reconocimiento durante un ataque con misiles simulado. El trabajo principal de la IA era encontrar lanzadores de misiles del enemigo mientras el humano buscaba aviones hostiles, ambos usando el radar del avión. Esta fue la primera vez que la IA controló un sistema militar.

Cabe destacar que estos agenciamientos no personifican un nuevo sujeto híbrido como lo sería el ciborg. No se trata de que nuestras máquinas biológicas –ojos o cerebro, músculo o nervio- estén siendo sustituidas por dispositivos mecánicos, sino que ya no hay modo de trazar límites precisos a lo que antes fuera nuestro dominio, nuestro “yo”. Ya sea en nuestra vida cotidiana (física o en las redes sociales), en la producción de bienes o en cualquier esfera del poder, todos formamos parte de diferentes agenciamientos. A ellos aportamos nuestra data, nuestros músculos y nuestra libido, y otro tanto harán muchos otros humanos desde distintas partes del planeta. Harán su contribución también las máquinas, ya sea a través de la información aportada por sus sensores, por la “manufactura” de sus brazos robóticos, y fundamentalmente, por los algoritmos que regulan todo el proceso y toman la mayor parte de las decisiones gracias a la ayuda de sus redes neuronales artificiales, operando a velocidad de microprocesador. Todas estas acciones, todos estos inputs, cortes y flujos, operan sincronizados bajo un mismo sistema de medición: el tiempo Unix, y cada vez más, el rol de decisión está siendo inexorablemente ocupado por el software.

2- ARTUµ, pronunciado R-2, en homenaje al robot de "Star Wars", R2-D2.

La definición tradicional de la inteligencia artificial (IA) es que es la inteligencia llevada a cabo por máquinas. Y esto hoy en día sólo tendría sentido si aclaramos que no nos referimos a máquinas técnicas, sino a máquinas abstractas. A agenciamientos heterogéneos en los que se ensamblan piezas de hardware, redes neuronales artificiales y, principalmente, fuentes de datos provenientes de las personas que, muchas veces en tiempo real, alimentan el sistema. A máquinas conformadas por hardware, software y humanos.

En cuanto al hardware, el "cerebro electrónico", que antes ocupaba enormes salas y requería de enormes cantidades de energía, hoy en día se ha miniaturizado y mimetizado a tal punto que ya no distinguimos bien qué aparato lo posee y cuál no. Objetos inteligentes de razonamiento distribuido, funcionando en forma casi autónoma y en red, permanecen ocultos tras todo tipo de funcionalidades: comunicación, control, entretenimiento, producción, transporte, transacciones financieras, seguridad. Electrodomésticos, relojes, automóviles, pero también, drones militares, granjas de minería de Bitcoin o almacenes de servidores de datos en la nube, todo unidos por cables terrestres y submarinos de fibra óptica y por satélites, constituyen la “parte ósea”, la parte material de la máquina de la IA.

Mientras que el software, que hasta ayer sólo era la interfaz para controlar a la máquina, ocupa un lugar intermedio entre el hardware y los seres humanos.

El software no es máquina técnica -claramente no es hardware-, pero tampoco es humano -su lenguaje binario nos resulta incomprensible: está hecho de ceros y unos, de cortes y flujos eléctricos-. Si en el siglo pasado la inteligencia artificial estaba fuertemente atada a un objeto específico -el ordenador-, en la era de Internet, los algoritmos han logrado independizarse de su "cuerpo" y hoy recorren las redes -y las nubes- procesando vorazmente toda información que encuentran a su paso. Hacia donde miremos, algoritmos manejan y organizan constantemente esta masa de información, inabarcable para el ser humano. Todo es medido y almacenado: desde los datos generados por los propios humanos- a través de redes sociales, correo electrónico o búsquedas en Google-, pasando por las huellas de sus transacciones -compras, transferencias, facturaciones, llamadas telefónicas- las huellas que dejan sus cuerpos -mediante las cámaras de vigilancia, huellas digitales y de ADN-, y hasta las que generan las propias máquinas – con sus sensores de localización, de altura, de presión, de sonido.

La inteligencia artificial basada en redes neuronales no es solo una nueva herramienta informática, sino que representa el comienzo de un cambio fundamental en la forma en que se escribe el software. Son lo que Andrej Karpathy, el director de IA en Tesla, denomina software 2.0.

El software 1.0, que es con el que todos estamos familiarizados y que está escrito en lenguajes como Python o C ++, consiste en instrucciones para un ordenador escritas por un programador. Al escribir el código, el programador vincula cada línea específica del programa con algún comportamiento deseable en la máquina.

Por el contrario, el software 2.0 está escrito en pesos de redes neuronales. Entrenar una red neuronal consiste en ajustar cada uno de los pesos de las neuronas que forman parte de la red, para que las respuestas se ajusten lo más posible a los datos que conocemos. Ningún humano está involucrado en escribir este código porque hay demasiados pesos -las redes típicas pueden tener millones, y codificar directamente en pesos es algo dificultoso. En cambio, lo que se hace es especificar determinadas reglas según las cuales debe comportarse el programa, se calibran los diferentes pesos y se usan los recursos computacionales disponibles para buscar los resultados que satisfagan esas restricciones, entrenadas con algoritmos como los de retropropagación y de descenso de gradiente estocástico.

Según Karpathy, la mayor parte de los programadores del mañana no se dedicarán a hacer complejos desarrollos de software, sino que se dedicarán a recopilar, limpiar, etiquetar, analizar y visualizar los datos -producidos por humanos- que alimentan las redes neuronales.

Como consecuencia, dado que el conjunto de instrucciones de una red neuronal es relativamente pequeño, es significativamente más fácil implementar este software mucho más cerca del silicio, sin capas intermedias, sin sistemas operativos. El mundo cambiará cuando la inteligencia de baja potencia, encapsulada en chips pequeños y económicos, se generalice a nuestro alrededor. Del paradigma de la máquina universal de Turing (una única máquina que puede ser usada para computar cualquier secuencia computable) a los ASIC (circuitos integrados de aplicación específica, no programables, sólo capaces de resolver un problema en específico). Esta cuestión la aborda Friedrich Kittler en There is no Software 3. Partiendo de la tesis de Church-Turing, y de que el mundo físico es continuo -no discreto- y de máxima conectividad, sugiere que el único modo de hacer "computable" al universo sería con "hardware puro" que no necesite software.

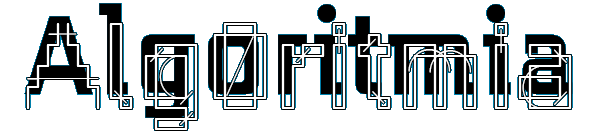

Every Icon, Software art, 1997, John F. Simon

Every Icon (Todo icono) muestra cada combinación posible de pixeles en una cuadrícula de 32 por 32, recorriendo sistemáticamente todo icono concebible. La obra nos recuerda al Aleph borgiano, “ese punto del espacio que contiene todos los puntos”, en el que confluyen infinito y eternidad. Un Aleph maquínico que se convierte en un intento inalcanzable de probar si la realidad es o no computable, si toda acción, si todo ente es o no reducible a código.

Podemos ver ya esta tendencia en casos como el de Google, que ha revelado que para procesar las solicitudes de RankBrain, su algoritmo de búsqueda, en lugar de ordenadores corrientes basados en CPUs , sólo utiliza TPUs (unidades de procesamiento tensorial), que son circuitos integrados de aplicación específica y aceleradores de IA, desarrollados exclusivamente para el aprendizaje automático por el propio Google.

3- “There is no software” (No hay software). Ensayo publicado en CTheory, en 1997, en el que sugiere que la única forma de estar a la altura de la complejidad física del mundo es utilizando "sistemas no programables" hechos de "hardware puro". En teoría de la computabilidad, la tesis de Church-Turing formula que todo algoritmo es equivalente a una máquina de Turing. Cuando la tesis es aplicada a la física tiene diversos significados: que el universo es una máquina de Turing y por lo tanto no es posible construir una máquina con mayor poder computacional (la capacidad de cómputo que puede contener el universo está acoplado al tipo de universo en el que vivimos). A esto se le ha llamado tesis de Church-Turing fuerte.

La IA, si bien se está acercando a la IAF (inteligencia artificial fuerte) 4, parece seguir un derrotero muy diferente al del razonamiento humano. Tanto las redes neuronales artificiales como la computación cuántica se basan en analizar multitud de datos, identificar patrones y dar una respuesta probabilística a la pregunta recibida, en muchos casos con una precisión y velocidad infinitamente mayor a un ser vivo. Sin embargo, en ningún caso entienden lo que su respuesta significa. No entienden lo que hacen, no hacen un razonamiento lógico ni matemático -como sí lo haría la computación tradicional o una máquina de Turing-. Según Katherine Hayles, la inteligencia algorítmica, debería entenderse como una forma de cognición no consciente 5, que resuelve problemas complejos sin utilizar lenguajes formales o inferencias deductivas. Los algoritmos aprenden a reconocer patrones sin tener que pasar por toda la cadena de análisis de causa y efecto -o de verdadero o falso en relación a la realidad- y sin tener siquiera que conocer el contenido de lo que están procesando.

El fallo al reconocer patrones puede llevar a errores inocentes -confundir perros chihuahuas con muffins de chocolate-, o a desvíos aberrantes como los mensajes racistas y machistas de Tay 6, el Tweetbot de Microsoft o el buscador de imágenes de Google, etiquetando a personas de piel negra como gorilas. Es que finalmente, toda la información inoculada al sistema de IA tiene origen humano-en gran parte de consumidores anglosajones- y, por lo tanto, sus mismos sesgos y prejuicios.

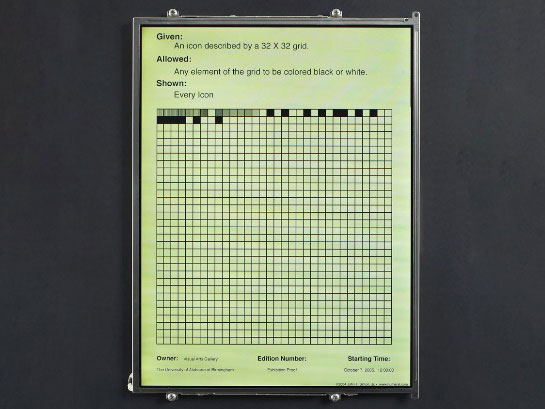

Cloud Face

Fotografías, algoritmo de reconocimiento facial, 2012, Shinseungback Kimyonghun

Los humanos frecuentemente solemos perder nuestra mirada tanto en las nubes, como en mármoles, en manchas de humedad o en la borra del café, lo que incita a nuestra imaginación a encontrar todo tipo de figuras, ya sean rostros, animales u objetos. En el caso de Cloud Face, lo inesperado, el error en la comunicación, el glitch en el sistema, provoca este efecto inesperado, esta serendipia en la “mente” de la máquina. [www]

Desde otra óptica, la ambigüedad en el reconocimiento de patrones fue utilizado por diversos artistas, como por ejemplo Salvador Dalí, quien a partir de este efecto desarrolló su método crítico-paranoico. En su libro “El mito trágico del ángelus de Millet” afirma que “…el cerebro humano, es capaz, gracias a la actividad paranoico-crítica, de funcionar como una máquina cibernética viscosa, altamente artística.”

La cognición maquínica es capaz de algunas proezas como la aceleración del descubrimiento de las vacunas contra el COVID-19 o el diseño de nuevos antibióticos, pero también de ser la herramienta que permite el surgimiento de granjas de fake news, Twitterbots o páginas automáticas para cazar clics y posicionarse entre los primeros resultados en los buscadores de Internet. Mediante algoritmos de PNL (procesamiento de lenguaje natural) como el GTP-2 o el aún no liberado GPT-3, ya es posible escribir textos artificiales que no se diferencian de los creados por una persona.

Predictive Art Bot

Procesamiento de Lenguaje Natural, website, instalación

Disnovation.org

La obra pone en acción un algoritmo que convierte los últimos titulares de los medios en conceptos artísticos, eludiendo el proceso creativo humano. Pero más allá de la mera automatización, la IA logra sorprendernos con asociaciones de ideas plausibles pero contraintuitivas e incluso desconcertantes. [www]

Máquina Cóndor

Máquina de poesía, 2006 -en proceso, Demian Schopf

La máquina genera poemas mortuorios que, segú las palabras del artista, “responden a relaciones de causa y efecto donde se conjugan la guerra con la economía y el bios con la polis y con el logos”. El poema no sólo comprende las estrofas resultantes, sino todos los datos sincronizados al unísono, la estructura relacional de esta máquina poética, máquina deseante y máquina de guerra, que se retroalimenta constantemente de la información que recibe del mundo. [www]

Estos algoritmos usan como “alimento” todo lo escrito anteriormente por humanos y publicado en Internet. Un mecanismo que desemboca en una paradoja o un fenómeno de recursividad bastante curioso. Los textos artificiales son leídos principalmente por algoritmos artificiales de los buscadores -haciéndolos más visibles en los resultados de búsqueda-y también por los propios algoritmos de PNL que los crearon. Por lo que, presumiblemente, la próxima versión de este algoritmo, el GTP-4, esté “intoxicada” con los textos producidos por sus versiones anteriores, alterando sus propios resultados y haciéndolos progresivamente menos humanos. Estaremos entonces ante una Internet cada vez más híbrida y con mayor cantidad de textos artificiales.

Perpetual Self Dis/Infecting Machine

Ordenador ensamblado a mano, virus Biennale.py, 2001, Eva y Franco Mattes

La obra, un ordenador que se infecta y se desinfecta indefinidamente de un virus desarrollado por los propios artistas, nos presenta a un Sísifo maquínico, cuya ceguera le impide ver lo vano de su trabajo, obedeciendo inexorablemente los comandos que lleva escritos en su memoria.

4- La IAF o también llamada inteligencia artificial general, es la inteligencia artificial que iguala o excede la inteligencia humana promedio, es decir, la inteligencia de una máquina que puede realizar con éxito cualquier tarea intelectual de cualquier ser humano.

5- Katherine Hayles (2014).

6- Tay era un bot de conversación de inteligencia artificial para Twitter creado por Microsoft en 2016. Tay causó controversia por entregar mensajes ofensivos y fue dado de baja después de 16 horas de lanzamiento.

Estamos viendo de qué manera el código informático avanza y se cuela en todos los estratos a su alcance, ya sea a nivel de las grandes infraestructuras, como en las pequeñas operaciones cotidianas. Administra la producción de bienes, pilotea drones, opera en los mercados financieros, pero también nos auxilia y conversa con nosotros a través de los asistentes virtuales o embellece nuestras fotos y selfies para que mejore nuestro posicionamiento en las redes sociales.

Pero a pesar de la impostada seducción artificial de su “voz”, de los vanguardistas diseños en los que se envuelve y de sus placenteras superficies táctiles que acariciamos innumerables veces al día, el código informático no es representativo. Su accionar está definido por su condición de semiótica asignificante 7, tornándose de ese modo invisible a nuestra percepción. Posee una estructura de unos y ceros que está moldeada por el hardware y surge de él sin generar ningún signo que pueda ser reconocible para el ser humano: sólo cortes y flujos de electricidad.

Untitledocument

Website, 2005, Ciro Múseres

La obra propone una navegación a ciegas y sin horizonte a la vista. Nos sumerge en un paisaje conformado sólo por signos que como humanos nada nos significan, por comandos o códigos maquínicos, articulados en una arquitectura también definida por las propios “accidentes geográficos” del navegador de Internet. Ventanas emergentes, barras de scroll, pull downs, dan forma a un universo plano, no representativo, asignificante y sin título. Un universo que convierte a nuestra navegación en un viaje sin rumbo y donde la única interacción posible es con la propia interfaz. [www]

Puede llevar a confusiones el hecho de que el software esté compuesto por diversas capas –entre el hardware y el usuario final- con diferentes niveles de representación. La capa de la interfaz gráfica es la que debe ser comprendida por el operador humano, pero por debajo, encontraremos otras capas cada vez más crípticas, como el sistema operativo, el BIOS, el Kernel y otros intérpretes, hasta llegar al propio lenguaje de máquina: el código asignificante puro, compuesto de secuencias de unos y ceros. Todo archivo digital, ya sean textos, pero también imágenes o sonidos, está “escrito” en ese lenguaje binario.

//**Code_UP

Proyecto online, 2004, Giselle Beiguelman

En este proyecto, la artista nos recuerda que las imágenes digitales son producto del lenguaje. De un lenguaje estrictamente programado. Partiendo de la película de Antonioni, Beiguelman experimenta con los diferentes parámetros que "describen" la imagen digital y nos sitúa en una trampa similar a la que arma Antonioni. Como el fotógrafo de Blow Up, nos encontramos finalmente con que las evidencias documentales no parecen dar cuenta de ninguna realidad. [www]

Para G. Deleuze y F. Guattari, existen dos modos de control sobre la sociedad: la sujeción social y la servidumbre maquínica 8. Mientras que el primero es un mecanismo de sometimiento social del individuo y actúa a nivel molar a través de estrategias de codificación de la conducta, la servidumbre o esclavitud maquínica, opera a nivel infrapersonal e infrasocial, es decir, a nivel molecular, a través de mensajes no lingüísticos -como lo es el código informático-.

En los tiempos en que se definieron esos conceptos, se tomaba en cuenta, por ejemplo, el impacto de la televisión y de qué manera sus mensajes se abrían paso no sólo a través del lenguaje, los discursos y otros modos de subjetivación, sino que, al mismo tiempo, se emitían señales asignificantes que incidían en tanto afectos o perceptos, intentando llegar a estratos más allá de lo lingüístico y de la representación.

Esta concepción no deja de ser antropocéntrica ya que lo que hoy tenemos son agenciamientos en los que el humano ya no funciona como receptor de una propaganda subliminal ni como blanco de un bombardeo ideológico, sino como un engranaje más -ya sea como productor de datos o como consumidor- dentro de una máquina heterogénea controlada por los algoritmos que la regulan.

So much for self control

GIF animado (edición limitada), 2019, Martina Menegon

El surgimiento del ciberespacio ha implicado una necesidad de redefinir el nuevo papel del sujeto, sus límites, su “fisicalidad” en tanto entidad virtual. ¿Cómo se negocia el espacio del yo en un agenciamiento maquínico? ¿Qué sucede cuando éste no responde a la función que se le ha asignado como engranaje? La obra hace visible lo que este error en el sistema genera: la perpetua negociación, la resistencia, la línea de fuga, el sabotaje al autocontrol. [www]

Pero más allá de esta aclaración, las dos formas de control social se mantienen. Por un lado, la sujeción, cuando nos sentamos a operar un programa o interactuamos socialmente por Internet bajo reglas que nos son impuestas y que no llegamos bien a comprender, y por otro la servidumbre, cuando nos quedamos hipnotizados por una catarata de imágenes “instagramadas”, acariciamos una interfaz edulcorada que nos envuelve, o hacemos clics aquí y allá, narcotizados y casi sin oponer resistencia. No más resistencia que cuando damos a aceptar las cookies, o a los “términos y condiciones” al instalar, emocionados, una nueva aplicación que ya no nos acordamos ni para qué servía.

McLuhan advierte sobre este nuevo escenario que impone la tecnología, llevándolo a reformular su famosa frase sobre los medios en estos nuevos términos: “el medio es el masaje” 9.

7- Guattari define al código informático como una de las semióticas asignificantes, tales como la moneda, los diagramas de la ciencia, la notación musical, etc., y les asigna un efecto desterritorializante y maquinocéntrico: “Las figuras semióticas asignificantes no segregan sólo significaciones. Profieren órdenes de marcha y detención y, sobre todo, desencadenan la "puesta en el ser" de Universos ontológicos.” F. Guattari (1996).

8- G. Deleuze y F. Guattari (2004).

9- “Todos los medios nos vapulean minuciosamente. Son tan penetrantes en sus consecuencias personales, políticas, económicas, estéticas, psicológicas, morales, éticas y sociales, que no dejan parte alguna de nuestra persona intacta, inalterada, sin modificar. El medio es el masaje. Ninguna comprensión de un cambio social y cultural es posible cuando no se conoce la manera en que los medios funcionan de ambientes.” Marshall McLuhan (1967).

Ante este escenario disruptivo, los flujos económicos también han vivido una revolución. En el ranking de 2017, por vez primera, las cinco mayores empresas del mundo fueron del sector digital. Petroleras, financieras, farmacéuticas o eléctricas, quedaban relegadas debajo de Apple, Google, Microsoft, Amazon y Facebook.

Como ya vimos, las nuevas economías se basan más y más en nuestro trabajo gratuito y voluntario- ya sea en forma de búsquedas en Internet, likes en redes sociales, o recomendaciones en tiendas online-, transformándonos en su producto, y explotando lo que podríamos definir como el oro del siglo XXI.

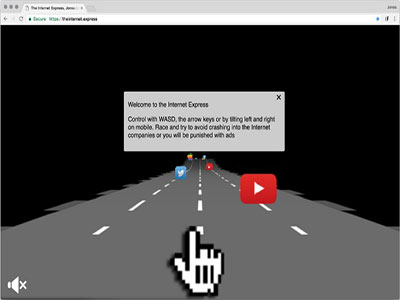

The Internet . Express

Website, 2017, Jonas Lund

“Navegar a menudo se siente como si estuvieras en un tren expreso de alta velocidad, rodeado de empresas que quieren capturar tus clics, mostrarte anuncios y monetizar tu comportamiento, por lo que TheInternet.Express te pone a prueba, ¿puedes evitar a los cinco grandes corriendo contra ti?, ¿o chocarás con ellos y serás sometido a más anuncios?”

El nuevo ecosistema, en el que se mueven a placer los cinco peces grandes, establece a su vez una dinámica fractal hacia los más pequeños: una nueva economía basada en el “like”, en seguidores e influencers. [www]

A pesar de vivir en un panóptico de hipervigilancia, lejos estamos de esas distopías represivas y dictatoriales de la ciencia ficción. Nos vigilan, sí. Pero a quienes nos espían -las grandes corporaciones digitales- no les interesa realmente lo que hacemos de nuestra vida. Salvo que infrinjamos alguna ley -y por consiguiente nuestros datos inmediatamente sean cedidos a los organismos de seguridad-, podemos subir a la red el material más absurdo, que sólo será decodificado y etiquetado por algoritmos a los que no les interesa su significado sino su valor-signo. No se asemeja tanto a una red de vigilancia sino más bien a una red para pescar datos. Para ello, lucharán por nuestra atención compitiendo por darnos la mejor interfaz, la más agradable, la más innovadora, la más adictiva, a cambio de nuestra contribución a su tarea de interceptación masiva del “Big Data”.

Pero al mismo tiempo que creamos plusvalía, nuestros clics generan una espiral productiva que determina el futuro de los objetos de consumo. Nuestro flujo de datos, la información de dejamos en la red, es utilizada en el diseño de nuevos productos. Productos “data driven”- productos diseñados a partir de los datos- ya han comenzado a inundar el mercado. Y no sólo se trata de gadgets tecnológicos sino también de productos culturales, libros, películas o hasta discursos políticos.

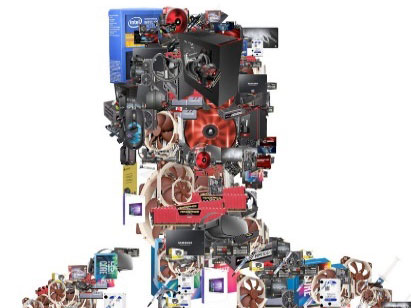

Customers who also bought

Imágenes producidas mediante un desarrollo de software, website de Amazon, 2017, Matthew Plummer Fernández

La obra consiste en una serie de retratos generados mediante un software que recopila datos de otros productos que han comprado los clientes en la web de Amazon. Las imágenes de estos elementos agrupados hacen visible cómo se perfila algorítmicamente y se clasifica cada tipo de consumidor. Pero al mismo tiempo, nos recuerda que nuestros flujos de datos, la información que dejamos en la red, es utilizada en el diseño de nuevos productos. [www]

Como vemos, el primer paso es perfilar, clasificar, asignar etiquetas descriptoras, aún aisladas. Pero esto permite luego generar todo un sistema de relaciones entre ellas, o lo que es lo mismo, crear una nueva ontología 10.

Las etiquetas, las keywords, constituyen por sí mismas en la red una ecología cambiante, por un lado, afectada por flujos e intensidades que hacen que las palabras suban o bajen su valor, pero por otro, modelan la red gracias precisamente al valor que adquieren. No al valor de uso, tal vez al valor de cambio, pero, sobre todo, al valor-signo 11.

Las keywords son fundamentales para posicionar páginas, productos, marcas (de objetos, personalidades o políticos). Su valor cambiante puede medirse diariamente y es el que nos cobra GoogleAds si queremos hacer publicidad con ellas. El copywriting SEO 12, es decir, los textos escritos únicamente para ser leídos por el algoritmo de Google con el objetivo de posicionarse en los primeros lugares de los resultados de búsqueda, se nutre fundamentalmente de estas palabras, a las que los eventuales clics de los usuarios le agregarán más valor.

Word Market

Portal de Internet, 2012, Belén Gache

Word Market es un portal de Internet dedicado a la compra-venta de palabras, utilizando para ello una divisa especial: el Wollar. En tiempos de creciente privatización de los espacios públicos y de profusión de leyes de copyright, Word Market permite a los usuarios operar y beneficiarse con las palabras y sus valores fluctuantes. El comprador recibe, asimismo, una cláusula de “Cease and desist” para enviarles a aquellos que pretendan usar “ilegalmente” sus palabras y un certificado de propiedad para poder demandar a todo aquel que, a pesar de todo, insista en utilizarlas. [www]

Otra de las estrategias SEO, es la de armar un entramado de enlaces cruzados entre distintas páginas web, ya que otra de las cosas que mira con atención el algoritmo de Google es qué tan bien relacionada está una página con el ecosistema general, qué tan alto en esta nueva pirámide capitalista se ubica. Páginas de mayor autoridad derraman su poder sobre las demás, mejorando el prestigio de éstas, que a su vez lo derraman en las páginas a las que enlazan, en una dinámica fractal de intensidades medibles que los especialistas bautizaron como link juice. Todas estas variables son mensurables y podemos consultar esta información pagando considerables sumas mensuales para acceder a ella, a las empresas que desarrollaron estos algoritmos de análisis.

Dentro de este agenciamiento, de esta máquina colectiva en la que participamos, en algún lugar entre los “me gusta”, entre las palabras que buscamos, entre aquellos que seguimos y nos siguen, se construyen los flujos de deseo.

Para Deleuze y Guattari, el deseo es producción. La producción deseante no es más que la producción social, produce lo real. La máquina deseante ocurriría no en alguien, sino en la línea de encuentro entre elementos de un agenciamiento. De allí que el deseo no tenga sujeto ni tienda hacia un objeto 13.

Si disponemos de toda la información necesaria, el deseo es medible, analizable, y de alguna manera, predecible. Una de las grandes ventajas diferenciales de Amazon es su rápido sistema de entrega. En muchos países la demora es de un día y en algunas ciudades, de pocas horas. Esto está muy bien, pero es mejorable: la forma más rápida de entregar un producto sería enviarlo antes de que el cliente lo compre. Trabajando sobre esa idea, Amazon ya patentó un sistema de entregas anticipadas basado en análisis predictivos de la información acumulada sobre sus clientes, basándose en su historial de compras y sus hábitos de consumo.

La utilización de datos a velocidad algorítmica no sólo se aprovecha en las áreas de producción o comercialización sino también en el ámbito financiero, en donde hoy en día gran parte de las decisiones las toman los algoritmos. Los robots bursátiles compran y venden a velocidad pasmosa, y con corazón de hielo, sin ojos más que para acumular alguna ganancia al final del día, sin importar enviar empresas a la bancarrota ni otros “daños colaterales”. Esta práctica, llamada High-Frequency Trading (negociación de alta frecuencia), en la que el operador humano tan sólo funciona como espectador, ya compone el 75% de las operaciones realizadas diariamente en las bolsas de EE. UU. y casi el 50% en las europeas.

La descodificación y desterritorialización que promueve el capitalismo, con su dinámica de erosión de todo tipo de barreras defensivas contra la globalización, va camino de ser el verdugo de sus pretendidos líderes y promotores: el capitalismo no necesita líderes ni promotores, ya que su fuerza de descodificación tiende a desbaratar toda jerarquía preestablecida. La banca, que ha impulsado la digitalización de la economía para favorecer el libre comercio y la inmediatez de las transacciones, está viendo cómo el dinero electrónico ha devenido en el origen de su propia destrucción. El sistema de banca electrónica ha preparado las condiciones para la aparición de otro tipo de dinero virtual: las criptomonedas P2P -como por ejemplo el Bitcoin- cuya principal característica es la de evitar el control regulador de la banca y de los estados. Esto ha llevado a la aparición de los préstamos P2P, lo que, tarde o temprano, provocará la desaparición de los bancos como los conocemos actualmente.

La desmaterialización total ya ha comenzado. Lo vemos en el caso de varios estados nórdicos que han anunciado la retirada de los billetes materiales, el pago con smartphone en cada vez mayor cantidad de tiendas o transportes y en general, con la cada vez menor circulación de metálico que ha promovido la pandemia.

Como señalaría Baudrillard, entramos en el dominio de la economía virtual, ya definitivamente liberada de las economías reales 14.

The Next Coin

Generador de criptomonedas, 2018, Martin Nadal

The Next Coin explora la fiebre del dinero criptográfico y nos propone una reflexión sobre el verdadero valor del dinero y cómo éste se genera. Después de todo, ¿no se genera todo el dinero de la nada? Si al abandonar el dólar el patrón oro, la economía quedó inmersa en una espiral de virtualidad, al aparecer el dinero electrónico y posteriormente las criptodivisas, hemos entrado ya en la fase de desmaterialización total. [www]

Enfocarse únicamente en las grandes corporaciones, en los grandes “jugadores” del reparto de la riqueza en Internet, puede que nos impida ver otros fenómenos que surgen también de lo digital, pero que establecen líneas de fuga hacia acontecimientos imprevistos. Los peces grandes pueden verse amenazados si una multitud de peces pequeños se organizan en su contra. Es el caso de Gamestop, en el que una multitud de inversores particulares que solían frecuentar el foro WallStreetBets de Reddit, decidieron unirse e ir en el sentido contrario al de algunos gigantes de los fondos de inversión de alto riesgo, que apostaban a la caída de las acciones de GameStop, una especie de Blockbuster de los videojuegos de consola. Valiéndose de las mismas herramientas digitales, pero utilizando ciertas debilidades del sistema, tácticas de retroingeniería, y resistencia, lograron hacer que estas empresas especuladoras perdieran miles de millones de dólares y al mismo tiempo rescatar a GameStop de la quiebra. Al menos por algunas semanas. Nada perdura eternamente en el dominio digital.

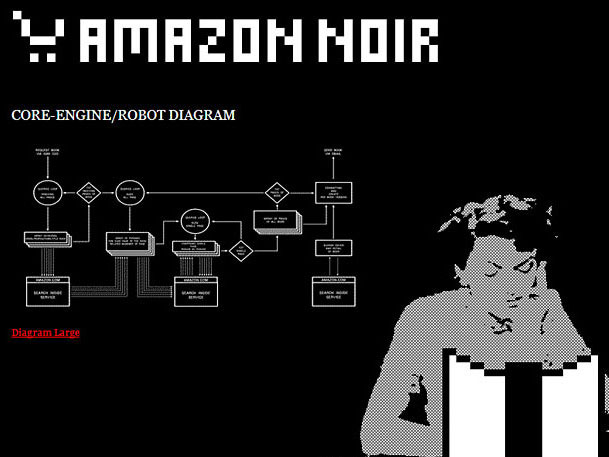

Amazon Noir (Hacking Monopolism Trilogy)

Acciones en Internet, 2006, Ubermorgen, Paolo Cirio Y Alessandro Ludovico

Esta trilogía de obras-algoritmo explotó las vulnerabilidades técnicas y económicas de tres importantes empresas de Internet, Facebook, Amazon y Google, reconfigurando la forma en que concentran, se apropian indebidamente y monetizan una gran cantidad de información e interacciones de los usuarios. Estas intervenciones tuvieron como objetivo desestabilizar sus modelos económicos y de marketing, haciendo visibles algunas de las implicaciones económicas de Internet, como la publicidad invasiva, la extracción de datos de los usuarios y la comercialización de bienes intelectuales. [www]

10- La “ontología”, en el terreno de la informática, cataloga las variables requeridas para un determinado conjunto en computación y establece las relaciones entre ellas. Delimita y describe un universo, sus individuos (instancias), clases (conceptos), atributos y relaciones.

11- “Tiempo atrás, en un oscuro proyecto de clasificación, yo había invocado una trilogía del valor. Una fase natural del valor de uso, una fase mercantil del valor de cambio, una fase estructural del valor-signo. […] Así pues, añadiré ahora una nueva partícula en la microfísica de los simulacros. En la cuarta fase, la fase fractal, o también fase viral, o también fase irradiada del valor, ya no hay ninguna referencia, el valor irradia en todas las direcciones, en todos los intersticios, sin referencia a nada, por pura contigüidad.” Jean Baudrillard, La transparencia del mal, 1990.

12- El posicionamiento en buscadores, optimización en motores de búsqueda o SEO (del inglés search engine optimization), es un conjunto de acciones orientadas a mejorar el posicionamiento de un sitio web en la lista de resultados de Google, Bing, u otros buscadores de Internet.

13- “¿Cuál es la naturaleza de las relaciones entre los elementos, para que exista el deseo, para que se conviertan en deseables? Es decir, yo no deseo una mujer, y me avergüenza decir cosas como estas: Proust lo ha dicho y en Proust es muy lindo, no deseo una mujer deseo a su vez un paisaje que está envuelto en esa mujer, un paisaje que de hecho no conozco y que presiento de tal manera que mientras no he desplegado este paisaje no seré feliz, es decir, mi deseo habrá fracasado, mi deseo quedará insatisfecho.” G. Deleuze, “Abecedario de Gilles Deleuze: D como Deseo”, 1988.

14- “Es el triunfo de la economía virtual liberada de las economías reales (no real sino virtualmente, por supuesto, pero es que hoy en día no es la realidad, sino la virtualidad la que ostenta el poder), de una economía viral que en este punto se une a todos los otros procesos virales.” Jean Baudrillard (2000).

El simulacro precede a la realidad. En la hiperrealidad de las redes sociales, es el código el que da forma a lo real. Baudrillard 15, cuando toma el cuento de Borges, donde los cartógrafos del Imperio dibujan un mapa que acaba cubriendo exactamente el territorio, dirá que es el mapa, sus cartografías, sus coordenadas las que preceden, suplantan y engendran al territorio. Hoy en día, GoogleMaps, con sus coordenadas marcadas por el deseo, por likes, por recomendaciones, por seguidores y haters, redefine el territorio, le asigna valor-signo a cada región, traza sus rutas y recorridos.

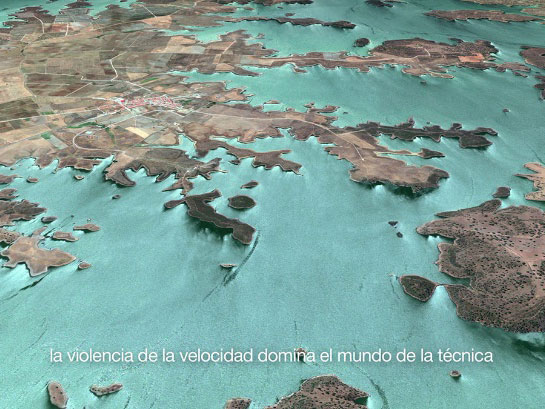

Guadiana

Vídeo, 2017, Antoni Muntadas

Un viaje a todo lo largo del río mediante la utilización de imágenes tomadas de Google Maps. Lo que aparenta ser un enigmático recorrido visual, se convierte sin embargo en un profundo análisis sobre nociones como desterritorialización y reterritorialización, deriva y control, mientras nos desplazamos por un paisaje atravesado por flujos, acumulaciones, apariciones y desapariciones.

La utilización de las imágenes satelitales, y el correspondiente desplazamiento desde el paisaje horizontal al paisaje cenital, aumenta esa tensión entre lo visual y lo analítico, entre mapa y territorio, entre naturaleza y código.

Los productos de las tiendas de venta online, los teleoperadores o hasta los repartidores a domicilio, pero también los productos culturales, académicos o artísticos están expuestos a esta nueva dinámica que generan los algoritmos de recomendación. Del mismo modo en que el algoritmo de Uber se convierte en el jefe de miles de conductores, la estructura de "likes" moldea un complejo mecanismo de seducción basado en seguidores, en el cual, como una enigmática bandada de pájaros, no terminamos nunca de saber si es el líder quien dirige a la bandada de seguidores, o son los "likes" de los seguidores quienes modifican la ruta del líder.

Esta dinámica configura una nueva pirámide del poder, una pirámide del capitalismo electrónico que podríamos representar en forma similar a la famosa ilustración publicada en el Industrial Worker 16. Sólo que, en la base de la pirámide, en lugar de obreros o campesinos tendremos seguidores pasivos o “rebloggers”, mientras que, en lo alto, en lugar de monarcas o gobernantes, estarán los “influencers”, los más seguidos de las redes sociales. Si bien este fenómeno puede parecer trivial, hay que tener en cuenta que la misma dinámica se reproduce fractalmente en otros ámbitos. No sólo actúa en las redes sociales, sino que organiza y estructura en jerarquías todos los contenidos de la web. Ya sean textos banales o informativos, académicos o artísticos, sólo sobrevivirán aquellos que logren acomodarse en las primeras páginas de resultados de búsqueda de Google. Y a su vez, de forma similar se “valuará” la información con la que alimentar a los sistemas de inteligencia artificial. Valor-signo que se impone en todas nuestras interacciones en la red.

Inmersos en esa dinámica, lo que en principio nos mueve es el deseo de ascender en la pirámide, pero lo que inmediatamente después aparece, es el miedo a descender, a ser ignorado, a tener más manitas para abajo que para arriba. Aunque también aparece el miedo a la exclusión por olvido, si dejamos de estar presentes. Los algoritmos penalizan la falta de actividad, tanto o más que la falta de recomendaciones, por lo que, si mengua la actividad, también se desciende en la pirámide.

Trash Facebook

Página web intervenida, 2019, Michaël Borras a.k.a SYSTAIME

La obra nos hace reflexionar sobre nuestra propia participación en las redes y su proyección en un futuro distópico. Sistemas que parecen tener sus propias reglas -que ni siquiera conocemos-, con algoritmos que nos conducen hacia donde no necesariamente queremos ir -pero que terminamos aceptando como resultado de nuestras decisiones- y en el que nuestras interacciones son solo formalismos para que, hipnóticamente, continuemos alimentando sistemas colectores de Big Data. [www]

No solo en las redes sociales sino en toda la web existen este tipo de penalizaciones por inactividad. Lo que el algoritmo de Google promueve son las publicaciones frescas -lo que se conoce como freshness en jerga SEO-, ya que su algoritmo considera que lo nuevo, siempre será lo mejor. En la hiperrealidad, la alta definición del tiempo corresponde al tiempo real. 17 Es el punto en el que la historia lineal y la idea del progreso propias de la modernidad ya son imposibles; donde los acontecimientos ya no pueden ocurrir, anulados por la inmediatez del tiempo real.

Pero ya sea movidos por el miedo o por la ambición, ante la exigencia y el mandato de ascender, siempre será posible recurrir a la compra de enlaces o de seguidores. Por menos de mil euros y en cuestión de horas, podemos obtener unos veinte enlaces de calidad o cien mil seguidores, en cualquiera de las innumerables webs de posicionamiento SEO.

15- “La simulación no es ya la de un territorio, una existencia referencial o una sustancia. Se trata de la generación de modelos de algo real que no tiene origen ni realidad: un "hiperreal". El territorio ya no precede al mapa, ni lo sobrevive. De aquí en adelante, es el mapa el que precede al territorio, es el mapa el que engendra el territorio; y si reviviéramos la fábula hoy, serían las tiras de territorio las que lentamente se pudren a lo largo del mapa. Es lo real y no el mapa, cuyos escasos vestigios subsisten aquí y allí: en los desiertos que no son ya más del Imperio, sino nuestros. El desierto de lo real en sí mismo.” Jean Baudrillard (1981).

16- “La pirámide del sistema capitalista” es una ilustración crítica publicada en la edición de 1911 del Industrial Worker, un periódico estadounidense del sindicato Industrial Workers of the World. En ella se grafica la estratificación social por clases y la desigualdad económica de la sociedad capitalista.

17- “El concepto clave de esta Virtualidad es la Alta Definición. La de la imagen, pero también la del tiempo (el Tiempo Real), la música (la Alta Fidelidad), el sexo (la pornografía), el pensamiento (la Inteligencia Artificial), el lenguaje (los lenguajes numéricos), el cuerpo (el código genético y el genoma). La más alta definición del medio corresponde a la más baja definición del mensaje; la más alta definición de la información corresponde a la más baja definición del evento, etc.” Jean Baudrillard (1996).

Lo digital acentúa la inmovilidad que permite la ubicuidad. ¿Para qué viajar cuando se puede estar en varios lugares al mismo tiempo? ¿Para qué exponerse al virus si se puede teletrabajar?

La telepresencia marca nuevas conductas y nuevos protocolos sociales. Facebook, Twitter, Instagram, pero también Skype, Zoom, Twitch e incluso Second Life nos sirven para realizar todo tipo de excursiones, confesiones, seducciones e intercambios. Pero a diferencia de la experiencia unidireccional que brindaba la televisión y la consiguiente recepción por parte del público televidente de un discurso uniforme -dinámica que llevaría a McLuhan a desarrollar su concepto de Aldea Global-, Internet, con sus millones de avatares conectados punto a punto, hace estallar la Aldea Global en miles de aldeas globales, todas similares pero diferentes, como diferentes son los muros de cada uno de los usuarios de Facebook.

Happy Deep Love

Vídeo online, 2019, Michaël Borras a.k.a SYSTAIME

El artista remezcla imágenes web, utiliza sus gráficos y sus ornamentaciones, y construye con ellos un paisaje icónico de la cultura pop digital actual en el que, en contraste con lo que anuncia el título de la obra, queda anulada toda profundidad y en el que lo que vemos, queda encerrado estrictamente en el plano de su superficie. Una superficie hiperreal de abundancia, de deseos, de placer, que sólo tiene entidad dentro de los límites de la pantalla. [www]

Las redes digitales funcionan como un simulacro de espejo en el que se mira nuestro yo virtual. Sus algoritmos nos muestran lo que nos gusta y sólo lo que nos gusta. Vemos a quienes nos siguen o a quienes seguimos. Rodeados de publicidades de los productos que la IA piensa -sabe- que queremos comprar.

Ingresamos a la web para relacionarnos con el otro, con lo de afuera, con lo diferente y, sin embargo, lo que único que vemos es lo reflejado por nuestro historial de clics, por la información recogida como resultado de las órdenes que obedientemente hemos acatado: BUSCAR, COMPRAR, AÑADIR A LA CESTA, AÑADIR A LA LISTA DE DESEOS, SEGUIR, DEJAR DE SEGUIR, RECOMENDAR, ACEPTAR, ACEPTAR, ACEPTAR.

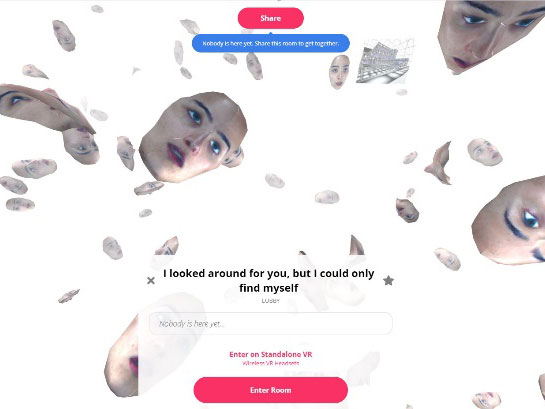

I looked around for you, but I could only find myself

WebVR Installation (Instalación web de realidad virtual), 2020, Martina Menegon

Este entorno virtual, en el que los usuarios tienen la opción de convertirse en parte de la obra utilizando la misma “cara” que el avatar de la artista , se nos presenta lo digital en tanto espejo. En la Internet 2.0 los algoritmos sólo nos muestran aquello que “nos gusta”, aquello que “seguimos”, lo que consumimos o lo que “buscamos”. [www]

La red nos devuelve un universo virtual moldeado a la imagen y semejanza no de nuestro yo, sino de nuestro simulacro. En la interacción virtual, no hay intercambios que no sean los precedidos por el algoritmo, por el mapa, por el código. Es el éxtasis de la comunicación 18 que anula toda posible comunicación.

IP Address: 81.39.251.110 (Madrid)

Unix Timestamp : 1613322476 (febrero de 2021)

www.gustavoromano.org

18- “No cabe duda de que el universo privado era alienante, en cuanto nos separaba de los demás, del mundo, en cuanto estaba investido de un muro protector, de un imaginario protector. Pero recogía también el beneficio simbólico de la alienación: el Otro existe. […] La obscenidad comienza cuando ya no hay espectáculo ni escena, ni teatro, ni ilusión, cuando todo se hace inmediatamente transparente y visible, cuando todo queda sometido a la cruda e inexorable luz de la información y la comunicación. Ya no estamos en el drama de la alienación, sino en el éxtasis de la comunicación.” Jean Baudrillard (1997).

Baudrillard, Jean. (1981). Simulacra and Simulation. Michigan: University of Michigan Press

Baudrillard, Jean (1991). La transparencia del mal. Barcelona: Anagrama.

Baudrillard, Jean (1996). El crimen perfecto. Barcelona: Anagrama.

Baudrillard, Jean (1997). El otro por sí mismo. Barcelona: Anagrama.

Baudrillard, Jean (2000). Pantalla total. Barcelona: Anagrama.

Deleuze, Gilles y Guattari, Félix (1985). El Antiedipo, Capitalismo y Esquizofrenia. Barcelona: Paidós.

Deleuze, Gilles y Guattari, Félix (2004). Mil mesetas, Capitalismo y Esquizofrenia. Valencia: Pre-textos.

Guattari, Félix (1996). Caosmosis. Buenos Aires: Manantial.

Guattari, Félix (2004). Plan sobre el planeta. Madrid: Traficantes de Sueños

Hayles, N. Katherine (2014). Cognition Everywhere: The Rise of the Cognitive Nonconscious and the Costs of Consciousness. New Literary History, 45(2), 199-220.

Karpathy, Andrej (2017) "Software 2.0", Medium. Recuperado el 6 de abril de 2018 de https://medium.com/@karpathy/software-2-0-a64152b37c35

Kittler, Friedrich (1999) Gramophone, Film, Typewriter. Stanford, California: Stanford University Press.

Kittler, Friedrich (2009) Optical Media. Cambridge. UK: Politi Press.

Kittler, Friedrich (1995) "There is no software", CTheory. Recuperado el 14 de junio de 2016 de www.ctheory.net/articles.aspx?id=74

McLuhan, Marshall y Fiore, Quentin (1967). The medium is the massage. Berkeley: Gingko Press.

McLuhan, Marshall (1996). Comprender los medios de comunicación. Barcelona: Paidos.

NETESCOPIO | MEIAC 2021